Как проверить, разрешена ли индексация страницы в robots.txt?

Когда поисковые роботы индексируют сайт, первое, на что они обращают внимание, это файл robots.txt. В нем находятся вся необходимые для них инструкции, включая информацию о том, какие страницы сайта нужно сканировать, а какие в этом не нуждаются. С помощью этого файла можно полностью запретить индексацию целых разделов сайта или отдельных его страниц. Например, не всегда нуждаются в индексации оставленные комментарии или служебные разделы сайта. С помощью грамотного составления файла можно ускорить индексацию нужных нам страниц.

Структура файла robots.txt.

В файле robots.txt присутствуют такие элементы как:

- User-agent. В директиве User-agent прописан доступ поисковиков к индексированию вашего сайта. Например, вы можете открыть доступ к сайту лишь для роботов Yandex.

- Disallow. Эти правила отвечают за то, какие страницы будут закрыты для индексации. Обычно тут прописывают служебные страницы и, иногда, страницы пагинации.

- Allow. В директиве Allow мы, наоборот, указываем те страницы и разделы, которые нуждаются в индексации.

- Sitemap. Sitemap же представляет собой ссылку на файл в формате .xml и включает в себя все доступные для индексирования страницы.

Постепенно список страниц растет и файл с правилами увеличивается. К тому же, очень часто случается, что правила индексации для роботов Yandex и Google отличаются. В таких случаях проверить отдельную страницу на индексацию становится уже не так легко. По мере наполнения сайта, при добавлении новых страниц и внесении изменений в файл robots.txt иногда случается, что нужные страницы выпадают из поиска. Поэтому через некоторое время после правок необходимо проверять, правильно ли роботы поисковиков прочитали информацию по измененным страницам.

Проверка в таком случае проводится двумя основными инструментами: Google Search Console и Яндекс Вебмастер. Далее мы рассмотрим подробнее эти 2 способа.

Проверка с помощью Яндекс Вебмастер.

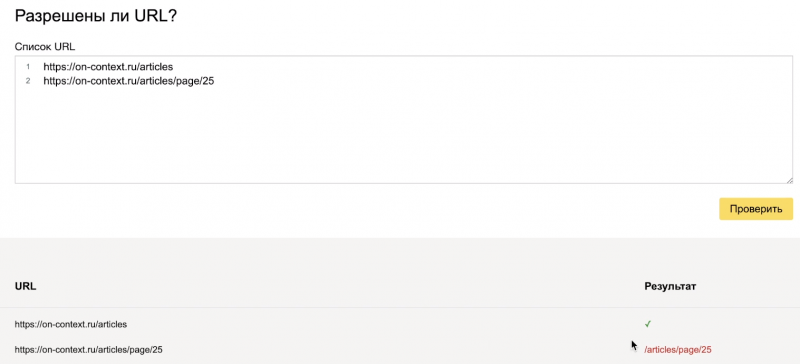

Для проверки нужной страницы нам необходимо зайти в Яндекс Вебмастер и выбрать раздел «Инструменты». Далее нажимаем кнопку «Анализ robots.txt». В результате Яндекс покажет наш файл robots.txt с возможными его версиями, если таковых несколько. Ниже будут располагаться результаты анализа наших правил. Тут Яндекс может выдать найденные им ошибки. Их стоит своевременно отслеживать и исправлять. Еще ниже находится окошко проверки нужной нам страницы. Для получения данных необходимо ввести туда адрес искомой страницы. После этого Яндекс покажет, разрешена ли индексация данного URL.

В нашем примере мы проверяли, разрешена ли роботам Яндекса индексация страницы со статьями и 25-я страница пагинации. Как мы видим, общая страница раздела статей индексируется, а страница пагинации закрыта, как и должно быть. Проверки особенно актуальны, если на сайте есть статьи, закрытые от индексации, комментарии к статьям, или вы закрываете страницы пагинации. В таких случаях можно случайно закрыть, например, весь раздел статей, или ошибиться при закрытии определенной статьи. Таким образом, проверки становятся необходимы при регулярных изменениях на сайте.

Проверка индексации с помощью Google Search Console.

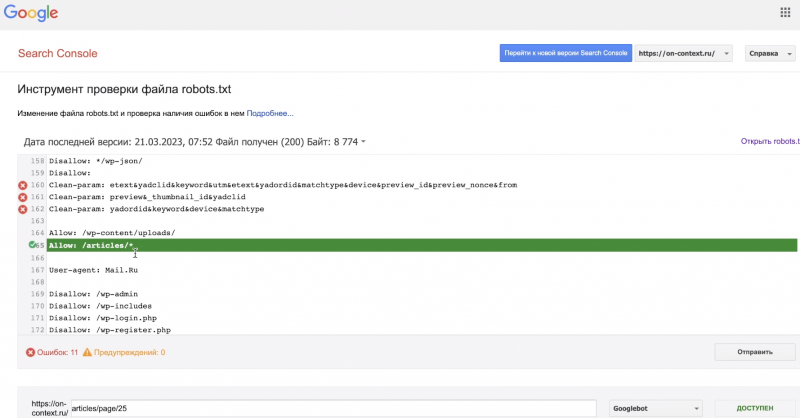

Войдя в Google Search Console, мы в схожей форме увидим нашу последнюю загруженную версию файла robots.txt. Под нашим кодом Гугл может показать найденные ошибки, которые рекомендуется постоянно отслеживать и исправлять.

Ниже располагается строка для проверки сканирования. Туда мы можем ввести интересующий нас адрес. Для примера введем тот же адрес страницы пагинации. Как мы помним, она должна быть запрещена для индексации.

Несмотря на зеленый цвет выделяющий страницу со статьями, мы выявили ошибку. Такая запись обозначает конфликт с запретом на индексацию определенных страниц этого раздела.

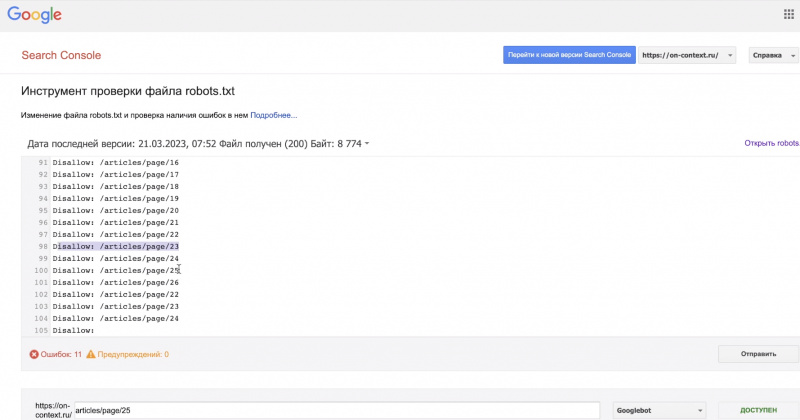

Запрещенные к индексации страницы пагинации, которые видны на картинке, будут проиндексированы благодаря записи с картинки выше. Следовательно, нам необходимо внести правки в файл, чтобы исправить ситуацию.

Подведем итоги.

Как мы видим из наших примеров, Яндекс и Гугл по разному читают записи в robots.txt. Яндекс правильно понял запись и исключил из индексации страницы пагинации. А Гугл запутался и проиндексировал все страницы, относящиеся к разделу статей. Поэтому необходимо проверять ваш файл с правилами для роботов с помощью обоих инструментов поисковиков.

Мы рекомендуем вам регулярно устраивать проверку, особенно при частом внесении правок на сайт и в robots.txt. Как мы видим, поисковики могут неправильно его прочитать, или вы при заполнении можете не учесть всех нюансов. Регулярная проверка позволит вам поддерживать все важные страницы в рабочем состоянии и помогать вам в продвижении сайта.

Частые вопросы (FAQ)

Вам могут быть интересны и другие наши статьи:

Релевантность сайта. Как измерить и повысить?

Один из главных помощников в SEO продвижении вашего сайта – его релевантность. Если ваш сайт релевантен запросам пользователя и довольно полно отвечает на его вопрос, он показывается выше в поисковиках. Ведь цель любой поисковой системы — чтобы пользователь оперативно решил свою задачу, а не продолжал листать результаты выдачи (или даже ушёл в другую систему). В […]

Контекстная реклама или SEO? Что выбрать в 2025 году?

Сразу скажем, что в этом материале не будет чёткой рекомендации «Выбирайте вот это». Но сориентируем, какие плюсы и минусы каждого варианта есть сейчас. Контекстная реклама Яндекс Директ — это про быстрые результаты. При удачно разработанном сайте и настроенной рекламе обращения и заказы можно начать получать в первую неделю. Если услуга/товар совсем новые для рынка или […]

Загрузка фида в поиск по товарам Яндекса

В своей работе мы постоянно ищем новые способы продвижения компаний наших клиентов, стараясь балансировать между наибольшей эффективностью и наименьшими затратами. Про один из таких способов, недавно появившийся в Яндексе мы хотели бы рассказать сегодня. Помимо улучшения позиций в поиске существует такой вариант продвижения сайта как поиск по товарам в Яндексе. Он отличается тем, что пользователь […]

Бесплатные знаниядля блогеров, предпринимателей, специалистов по продвижению

- Как сделать оптимизацию сайта и повысить позиции сайта в поисковых системах

- Еженедельные бесплатные видеоуроки, статьи и чек-листы

- 52 конкретных шага в году, чтобы продвинуть ваш сайт